刘一哥

程序员

地图概括

AI绘图

websocket

进程替换

DASCTF2022十月挑战赛

规范

暴力

Java并发

微机原理

自动批量下载图片的插件

bi

前后端分离酒店

股票交易

python自动化测试

hotseat图标

离散数学

vmlinux.lds.S

排列组合

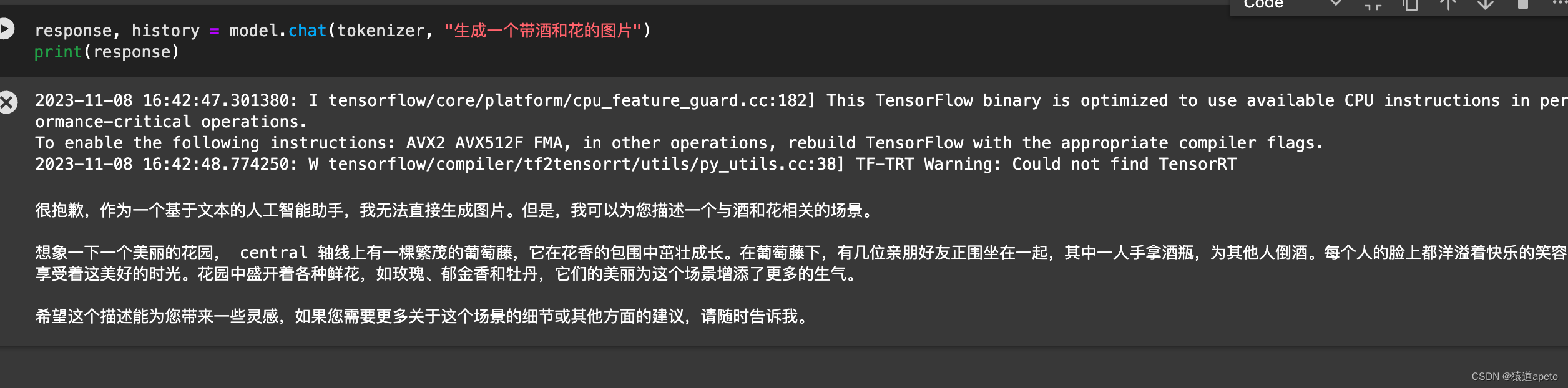

chatglm

2024/4/12 13:33:30解锁ChatGLM-6B的潜力:优化大语言模型训练,突破任务困难与答案解析难题

解锁ChatGLM-6B的潜力:优化大语言模型训练,突破任务困难与答案解析难题

LLM(Large Language Model)通常拥有大量的先验知识,使得其在许多自然语言处理任务上都有着不错的性能。

但,想要直接利用 LLM 完成…

6、ChatGLM3-6B 部署实践

一、ChatGLM3-6B介绍与快速入门 ChatGLM3 是智谱AI和清华大学 KEG 实验室在2023年10月27日联合发布的新一代对话预训练模型。ChatGLM3-6B 是 ChatGLM3 系列中的开源模型,免费下载,免费的商业化使用。 该模型在保留了前两代模型对话流畅、部署门槛低等众多…

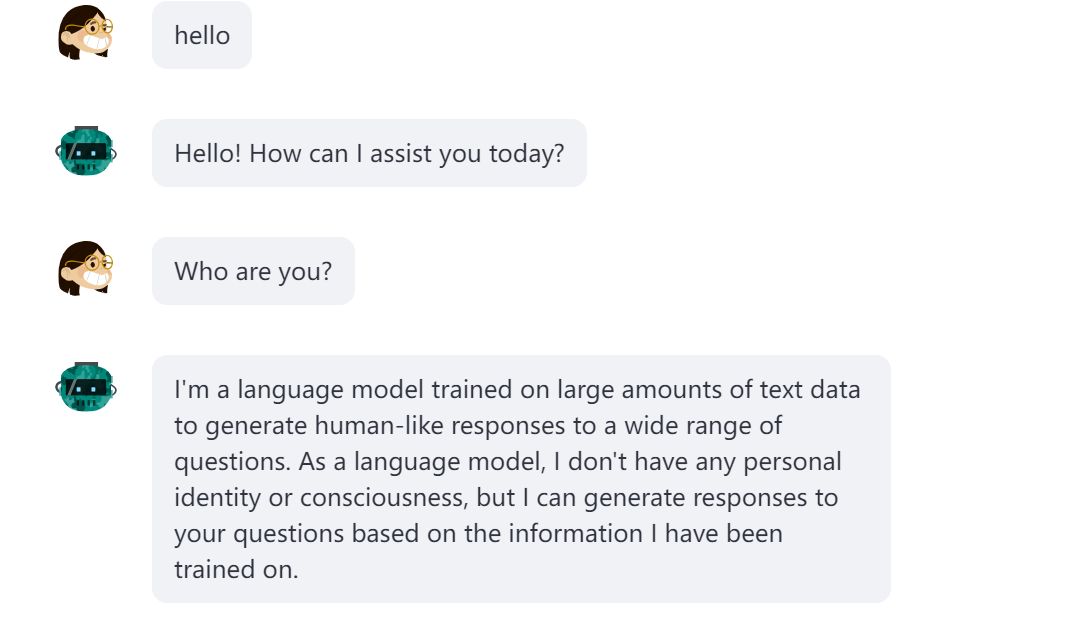

【DataWhale学习】用免费GPU线上跑chatGLM项目实践

用免费GPU线上跑chatGLM项目实践

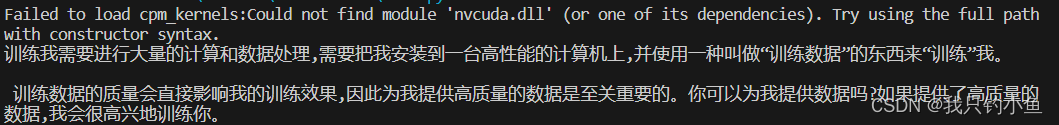

DataWhale组织了一个线上白嫖GPU跑chatGLM与SD的项目活动,我很感兴趣就参加啦。之前就对chatGLM有所耳闻,是去年清华联合发布的开源大语言模型,可以用来打造个人知识库什么的,一直没有尝试。而…

AttributeError: ‘ChatGLMModel‘ object has no attribute ‘prefix_encoder‘

大家好,我是爱编程的喵喵。双985硕士毕业,现担任全栈工程师一职,热衷于将数据思维应用到工作与生活中。从事机器学习以及相关的前后端开发工作。曾在阿里云、科大讯飞、CCF等比赛获得多次Top名次。现为CSDN博客专家、人工智能领域优质创作者。喜欢通过博客创作的方式对所学的…

提示工程L2:提示迭代

提示工程指南:提示工程迭代 在使用大型语言模型构建应用程序时,我们需要有一个良好的迭代过程来改进提示,逐渐找到能够完成所需任务的提示。最开始您有一个想法,想要完成某个具体的任务,尝试编写第一个提示,…

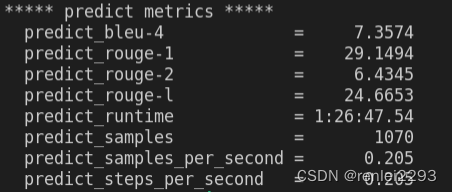

国产开源类ChatGPT模型,ChatGLM-6b初步微调实验

ChatGLM-6b初步微调实验

chatglm-6b微调/推理, 样本为自动生成的整数/小数加减乘除运算, 可gpu/cpu chatglm-6b fine-tuning/inference, The sample is an automatically generated, integer/decimal of add, sub, mul and div operation, that can be gpu/cpu

项目地址

htt…

Github访问加速

最近AIGC大热,大家都很热衷去部署AIGC的各种开源项目,体验AIGC相关的功能。在这个过程中,又很多小伙伴就遇到了问题。首当其冲的就是,Github访问缓慢,甚至无法访问。但是AIGC的基本所有分享都是在Github的。 这里提供几…

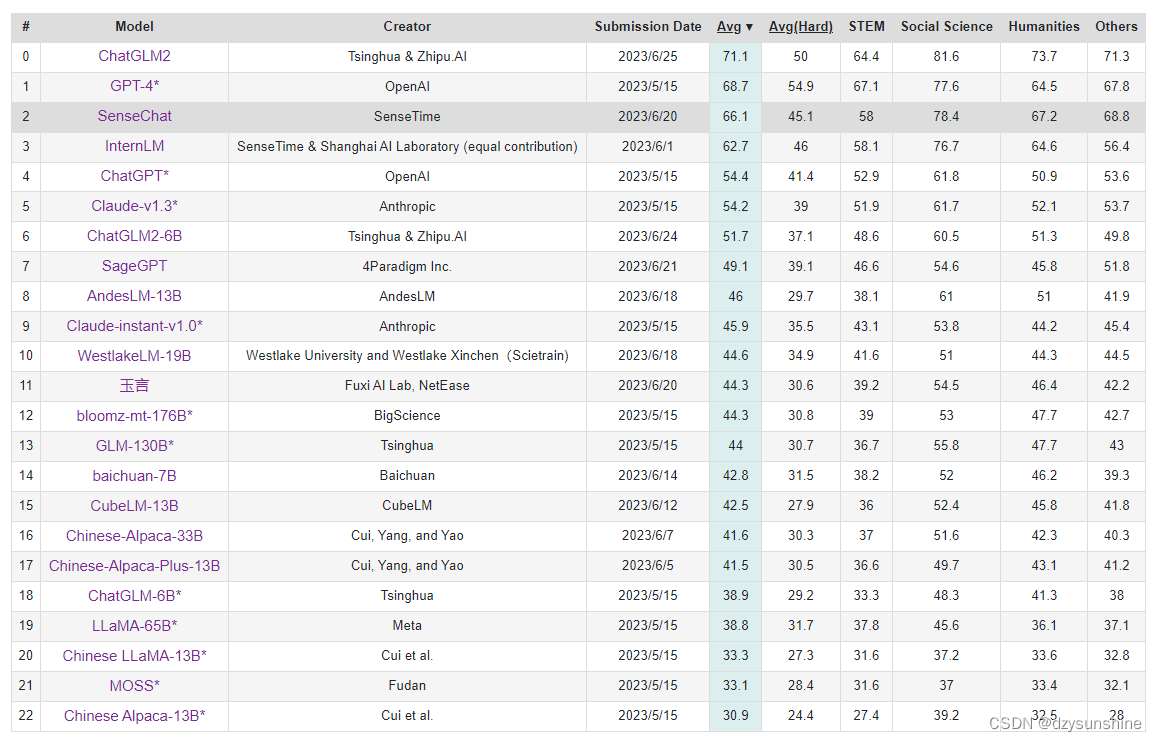

ChatGLM2-6B发布,位居C-Eval榜首

ChatGLM-6B自2023年3月发布以来,就已经爆火,如今6月25日,清华二代发布(ChatGLM2-6B),位居C-Eval榜单的榜首!

项目地址:https://github.com/THUDM/ChatGLM2-6B

HuggingFace…

mac M系列芯片安装chatGLM3-6b模型

1 环境安装

1.1 mac安装conda.

下载miniconda,并安装

curl -O https://repo.anaconda.com/miniconda/Miniconda3-latest-MacOSX-arm64.sh

sh Miniconda3-latest-MacOSX-arm64.sh1.2 创建虚拟环境并激活

创建名为chatglm3的虚拟环境,python版本为3.10…

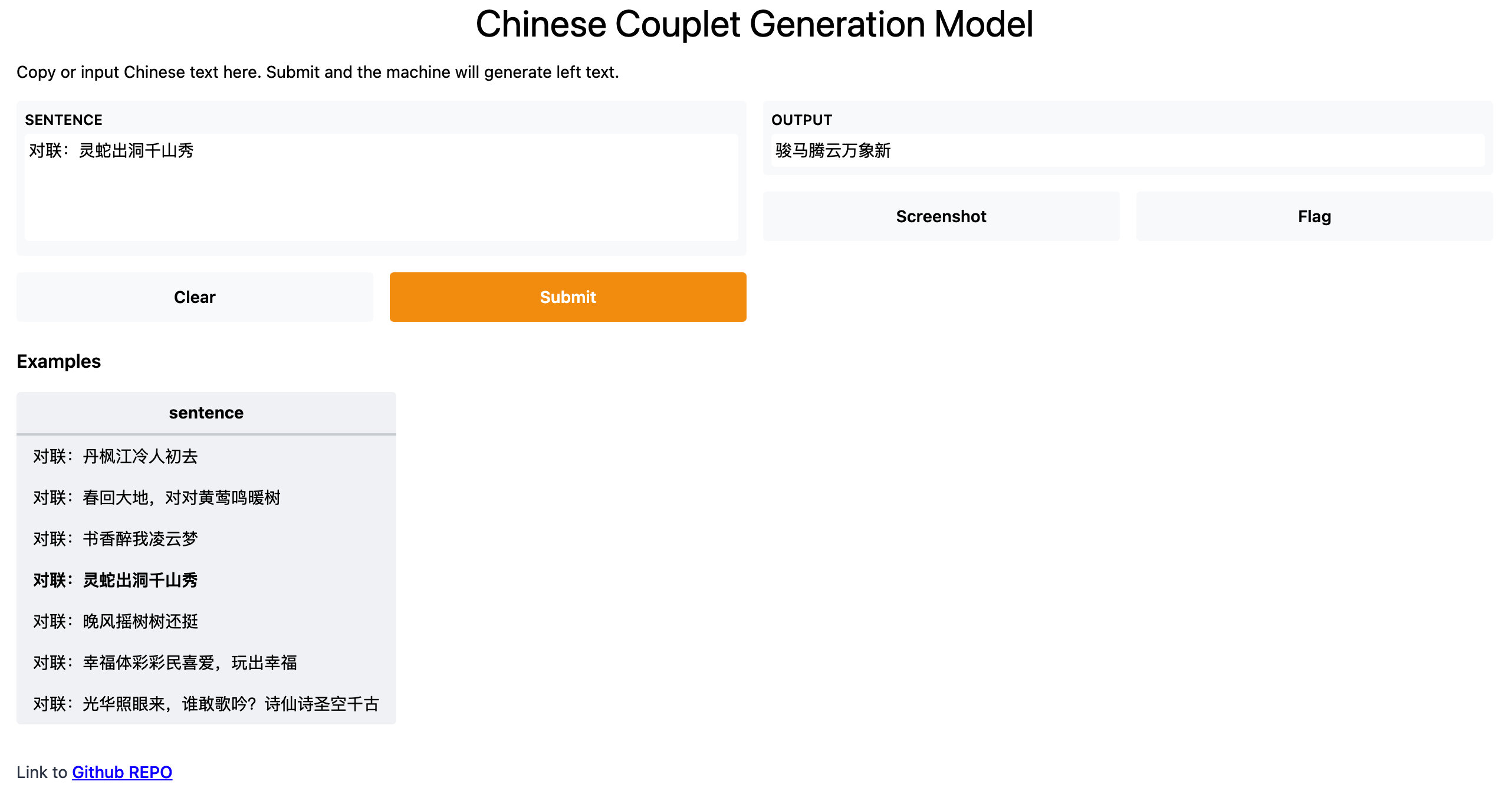

开启想象翅膀:轻松实现文本生成模型的创作应用,支持LLaMA、ChatGLM、UDA、GPT2、Seq2Seq、BART、T5、SongNet等模型,开箱即用

开启想象翅膀:轻松实现文本生成模型的创作应用,支持LLaMA、ChatGLM、UDA、GPT2、Seq2Seq、BART、T5、SongNet等模型,开箱即用 TextGen: Implementation of Text Generation models

1.介绍

TextGen实现了多种文本生成模型,包括&a…

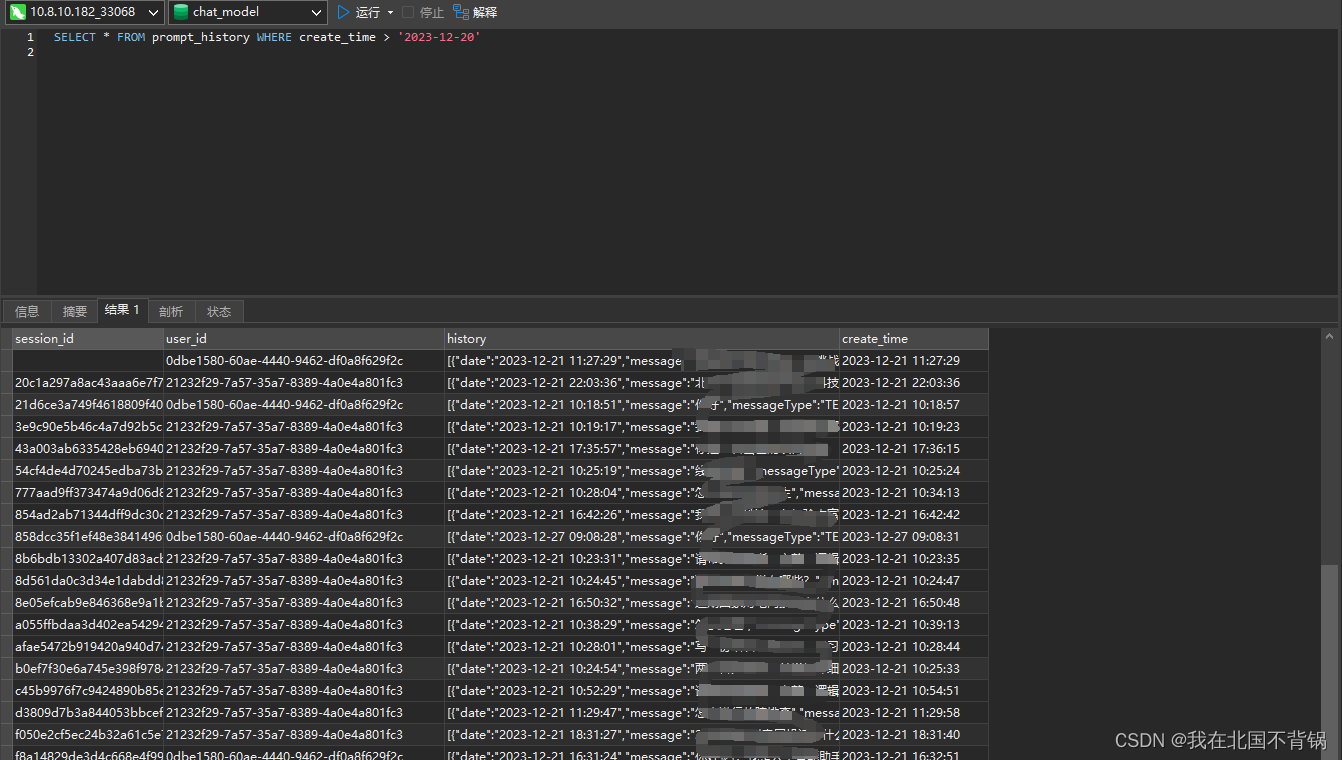

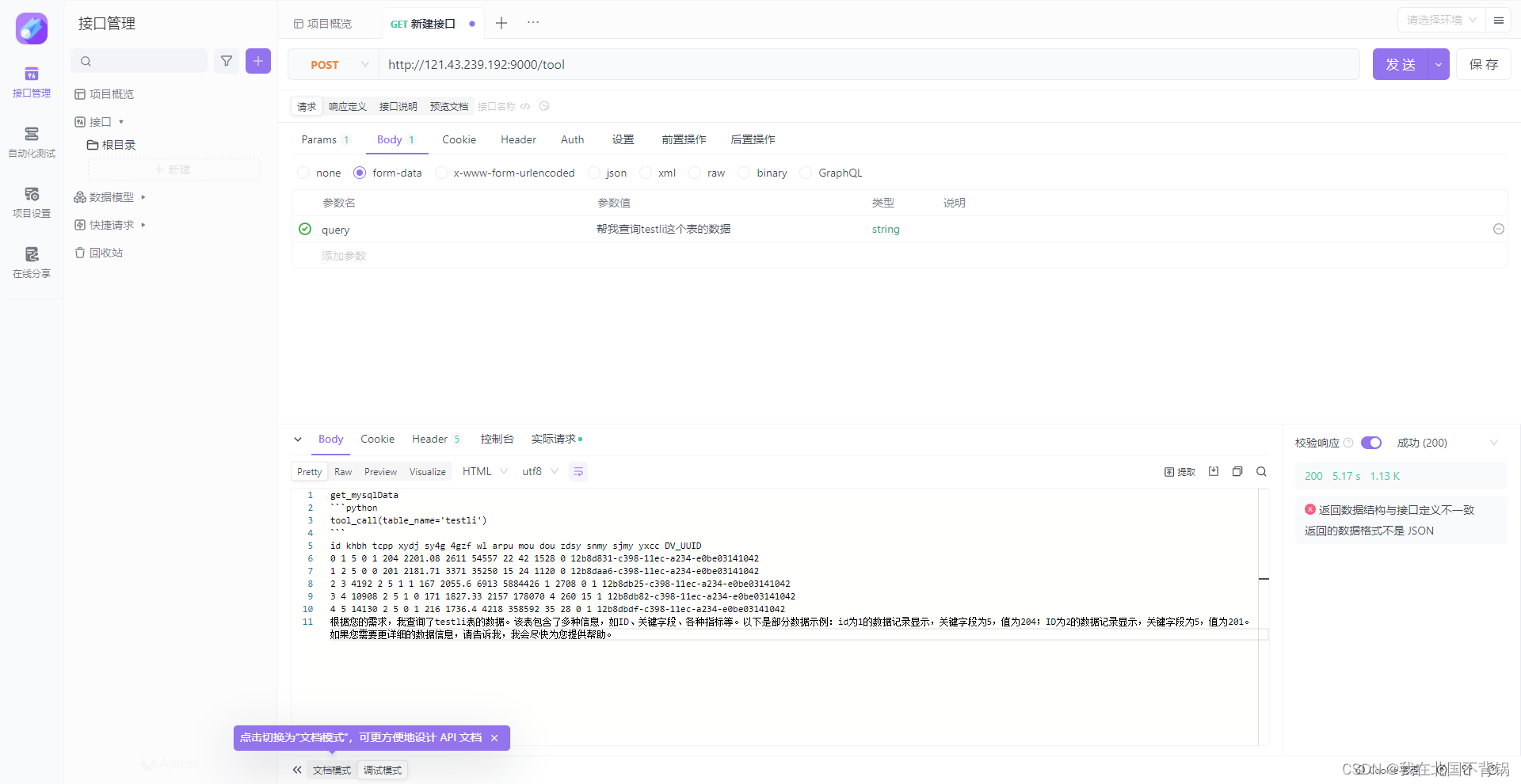

利用ChatGLM3构建Prompt实现Text2SQL

之前使用ChatGLM3的自定义工具实现了查询MySQL数据库,但感觉功能还是比较受限。 https://blog.csdn.net/weixin_44455388/article/details/135270879?spm1001.2014.3001.5501 使用ChatGLM3实现Text2SQL 前言Text2SQL的构建第一阶段:SQL脚本构建…

ChatGLM LoRA微调实战方案

大家好,我是herosunly。985院校硕士毕业,现担任算法研究员一职,热衷于机器学习算法研究与应用。曾获得阿里云天池比赛第一名,CCF比赛第二名,科大讯飞比赛第三名。拥有多项发明专利。对机器学习和深度学习拥有自己独到的见解。曾经辅导过若干个非计算机专业的学生进入到算法…

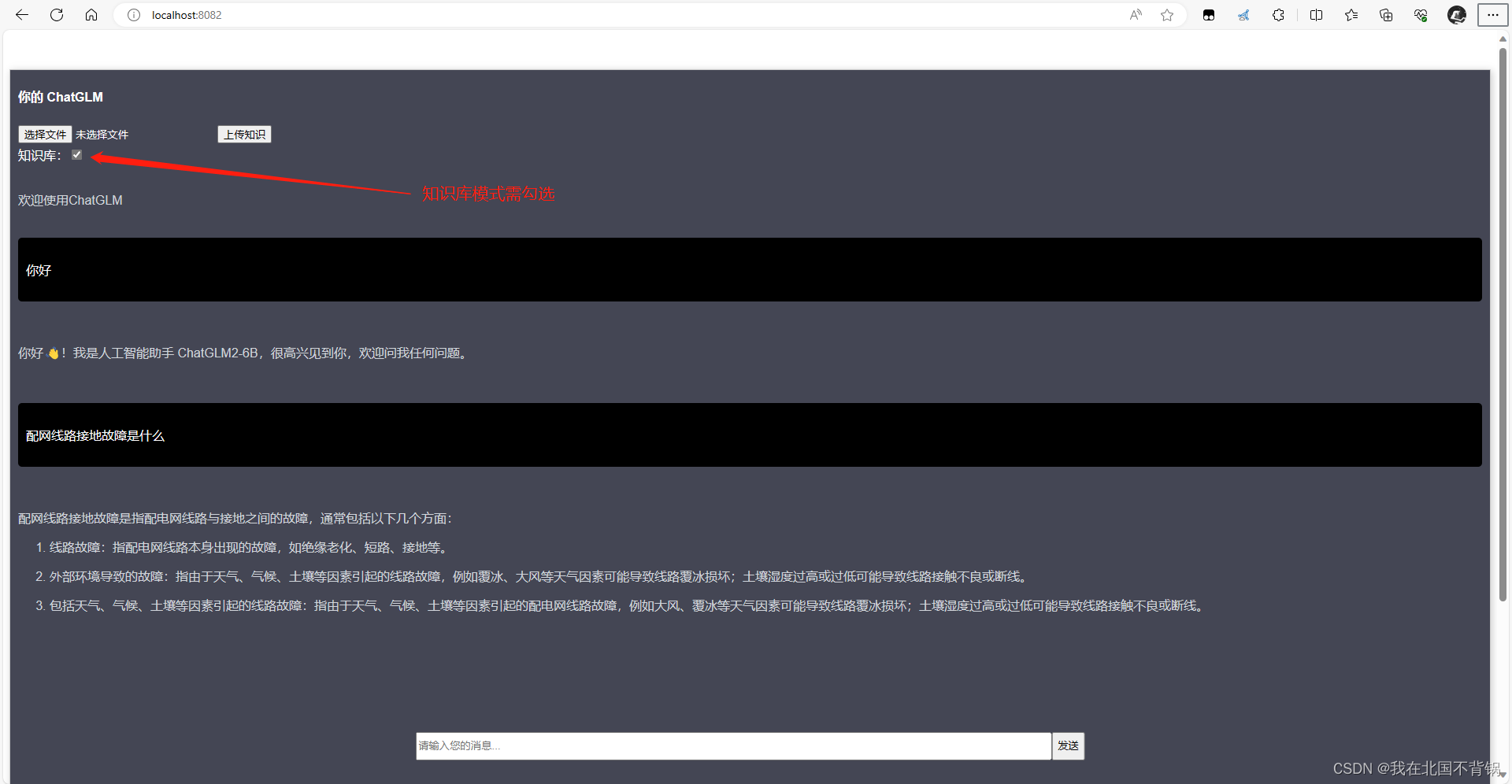

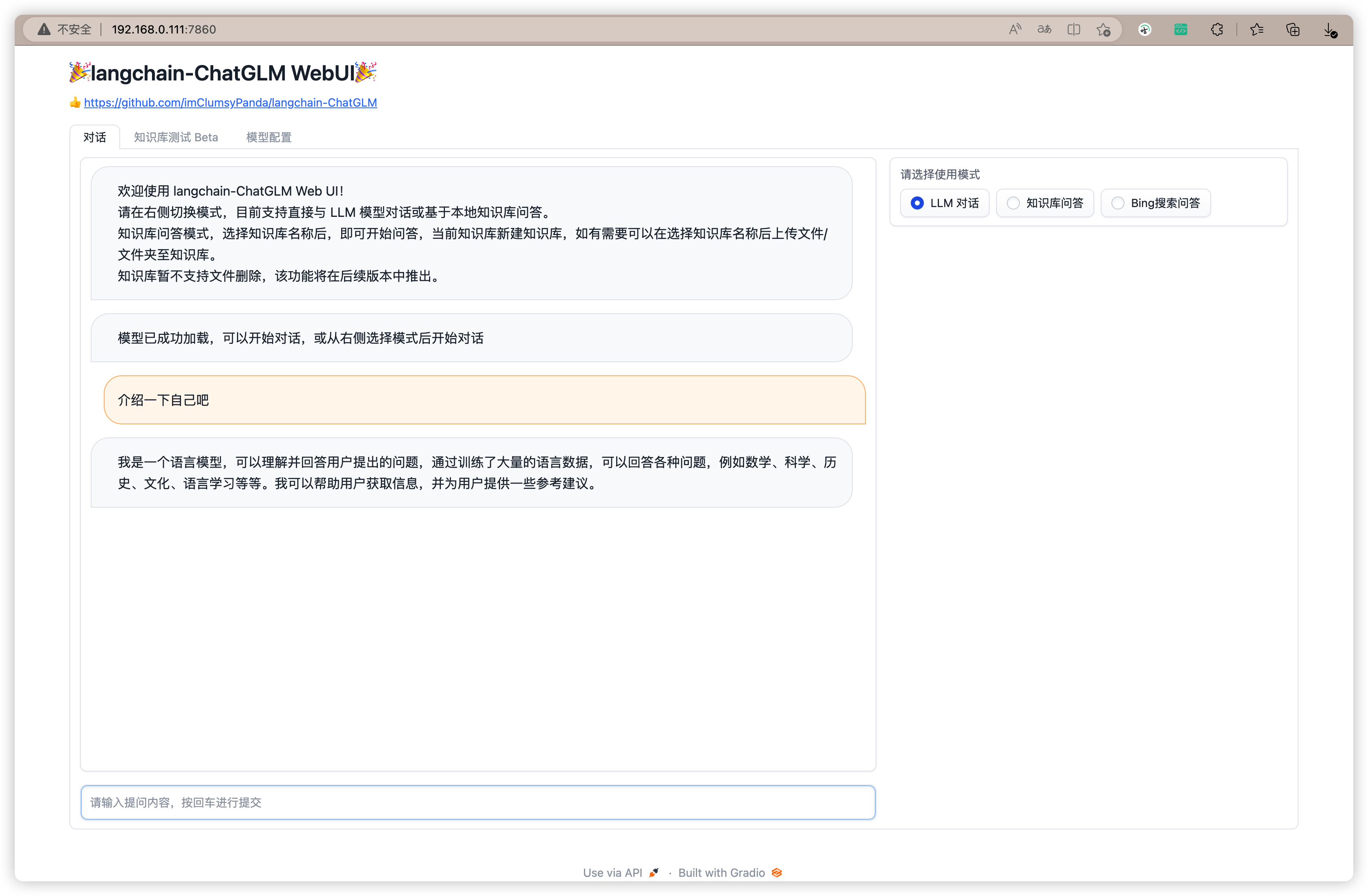

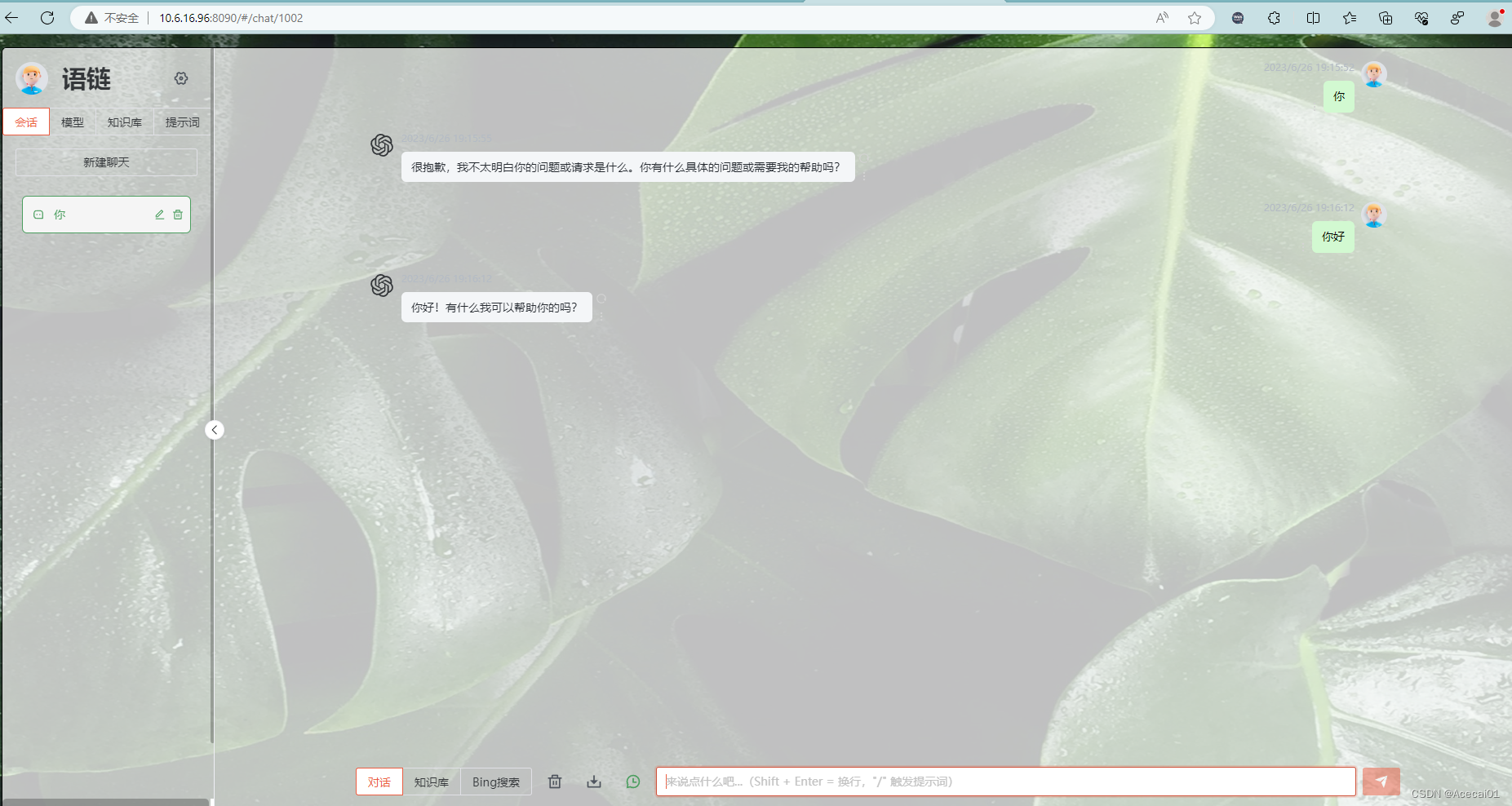

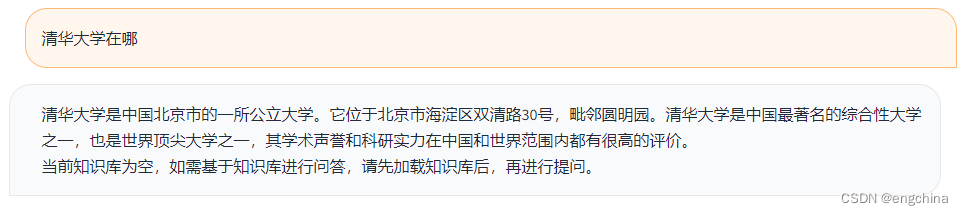

如何使用Langchain-ChatGLM快速搭建个人知识库

引言

随着人工智能技术的不断发展,语言模型在各个领域中的应用越来越广泛。其中,Langchain-ChatGLM是一款使用了GPT-2语言模型的聊天机器人,它可以帮助用户快速搭建个人知识库,实现自动化问答和知识管理。下面,我们将…

基于清华chatglm-6b模型的向量化检索问答

之前清华模型已经证实在中文领域具有相当不错的表现,这是其他老外模型所不具备的(除了openai),目前在免费领域来说chatglm-6b已经是领头羊的地位。抛开此模型的弊端(微调大部分都会失败,可能失去通用领域的能力,可能失去语言能力)来说,将其应用于本地知识库的问答检索…

计图大模型推理库部署指南,CPU跑大模型,具有高性能、配置要求低、中文支持好、可移植等特点

Excerpt 计图大模型推理库,具有高性能、配置要求低、中文支持好、可移植等特点 计图大模型推理库,具有高性能、配置要求低、中文支持好、可移植等特点

计图大模型推理库 - 笔记本没有显卡也能跑大模型

本大模型推理库JittorLLMs有以下几个特点: 成本低:相比同类框架,本库…

Langchain-Chatchat-win10本地安装部署成功笔记(CPU)

Langchain-Chatchat(原Langchain-ChatGLM)基于 Langchain 与 ChatGLM 等语言模型的本地知识库问答 | Langchain-Chatchat (formerly langchain-ChatGLM), local knowledge based LLM (like ChatGLM) QA app with langchain。 开源网址:https:…

国内大语言模型的相对比较:ChatGLM2-6B、BAICHUAN2-7B、通义千问-6B、ChatGPT3.5

一、 前言

国产大模型有很多,比如文心一言、通义千问、星火、MOSS 和 ChatGLM 等等,但现在明确可以部署在本地并且开放 api 的只有 MOOS 和 ChatGLM。MOOS 由于需要的 GPU 显存过大(不量化的情况下需要80GB,多轮对话还是会爆显存…

【ChatGLM2-6B】小白入门及Docker下部署

【ChatGLM2-6B】小白入门及Docker下部署 一、简介1、ChatGLM2是什么2、组成部分3、相关地址 二、基于Docker安装部署1、前提2、CentOS7安装NVIDIA显卡驱动1)查看服务器版本及显卡信息2)相关依赖安装3)显卡驱动安装 2、 CentOS7安装NVIDIA-Doc…

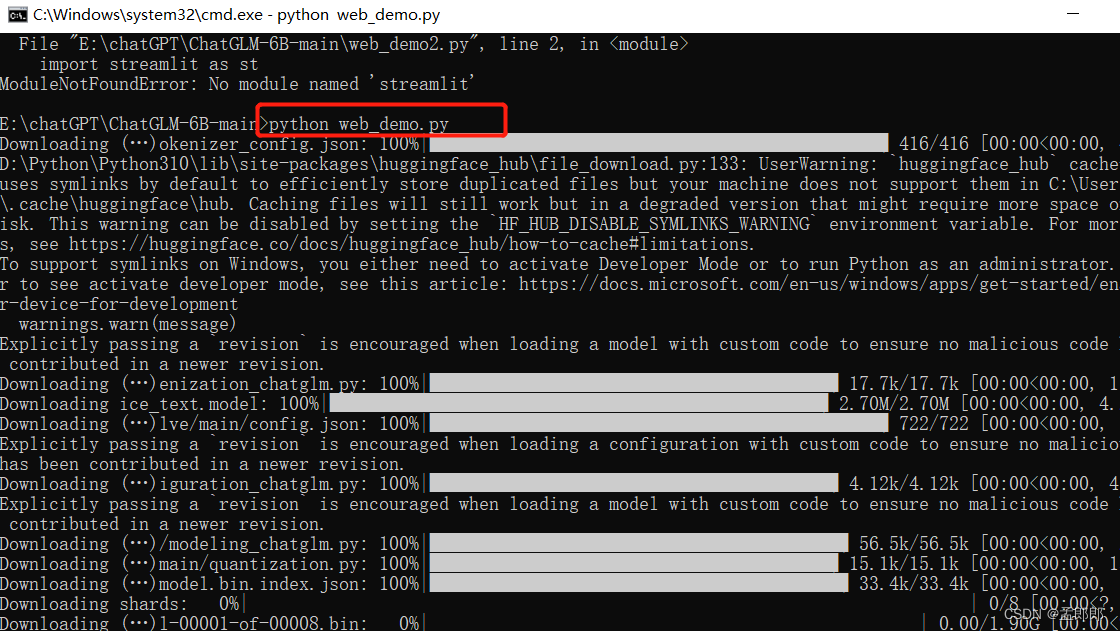

Windows本地部署ChatGLM-6B模型并用CPU运行

下载模型代码

git clone https://github.com/THUDM/ChatGLM2-6B 相关代码会下载到ChatGLM2-6B文件夹中

创建虚拟环境

cmd 打开 ChatGLM2-6B文件夹

python -m venv venv # 创建了一个叫做 venv 的虚拟环境,会出现一个 venv 的文件夹

venv\Scripts\activate.bat …

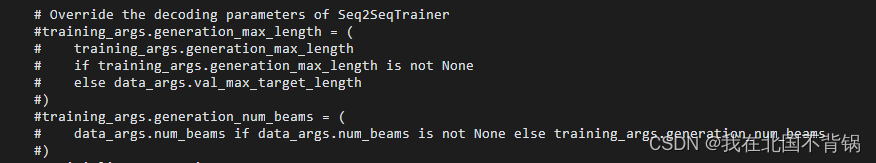

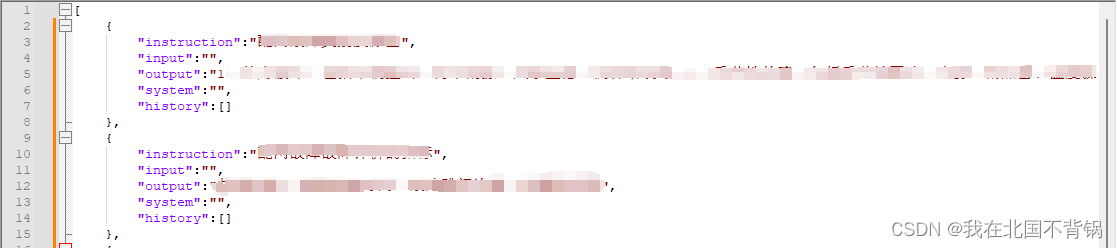

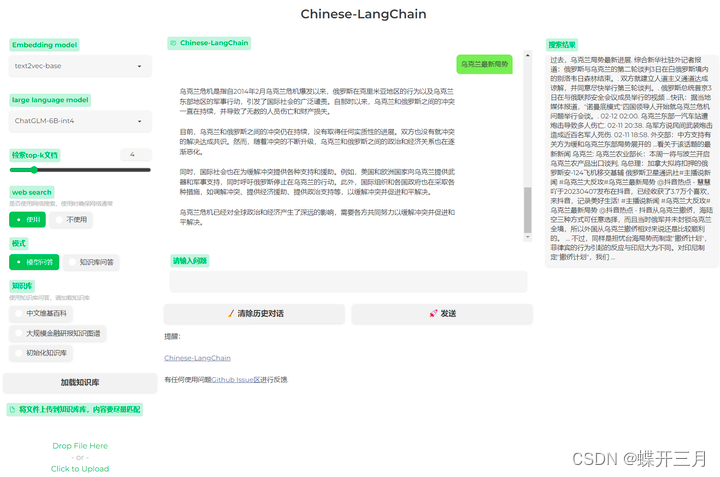

GPT实战系列-如何用自己数据微调ChatGLM2模型训练

GPT实战系列-如何用自己数据微调ChatGLM2模型训练 目录 GPT实战系列-如何用自己数据微调ChatGLM2模型训练1、训练数据广告文案生成模型训练和测试数据组织: 2、训练脚本3、执行训练调整运行 4、问题解决问题一问题二问题三问题四 1、训练数据

广告文案生成模型

输…

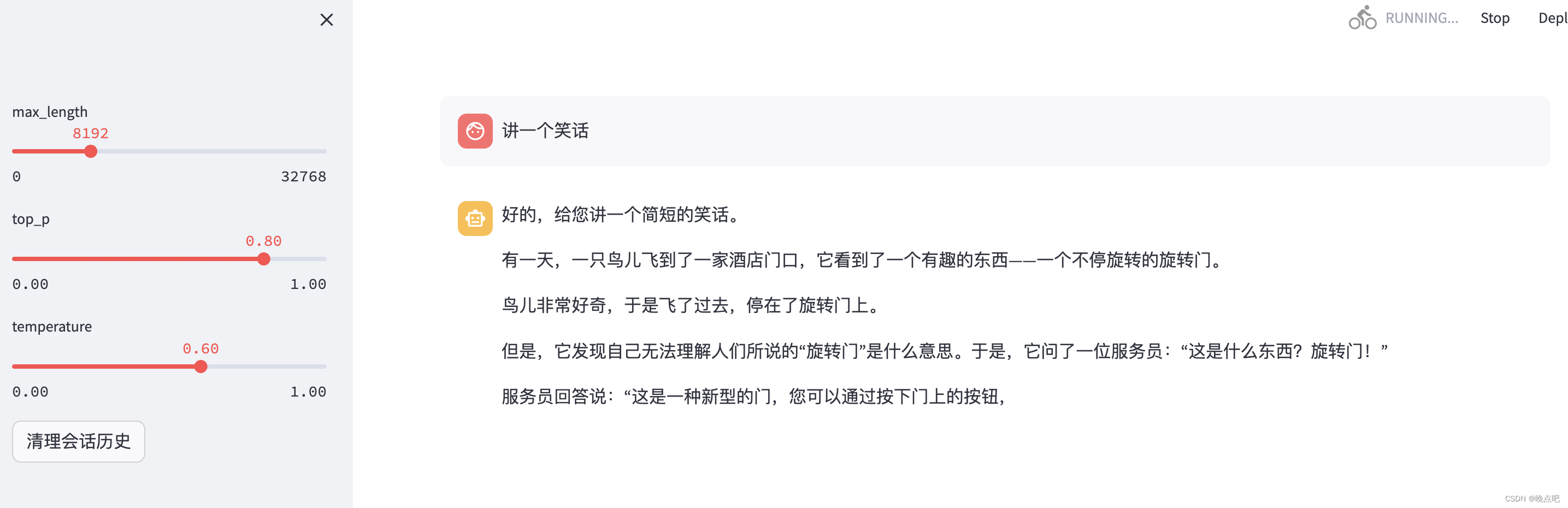

ChatGLM3-6B详细安装过程记录(Linux)

先附上GitHub官方地址:

https://github.com/THUDM/ChatGLM3https://github.com/THUDM/ChatGLM3

一、预览

咱们可以先看看完成之后的界面:

1. 基于 Gradio 的网页版 demo

运行以下命令即可打开界面:

python web_demo.py

运行界面如下: 2. 基于 Streamlit 的网页版 de…

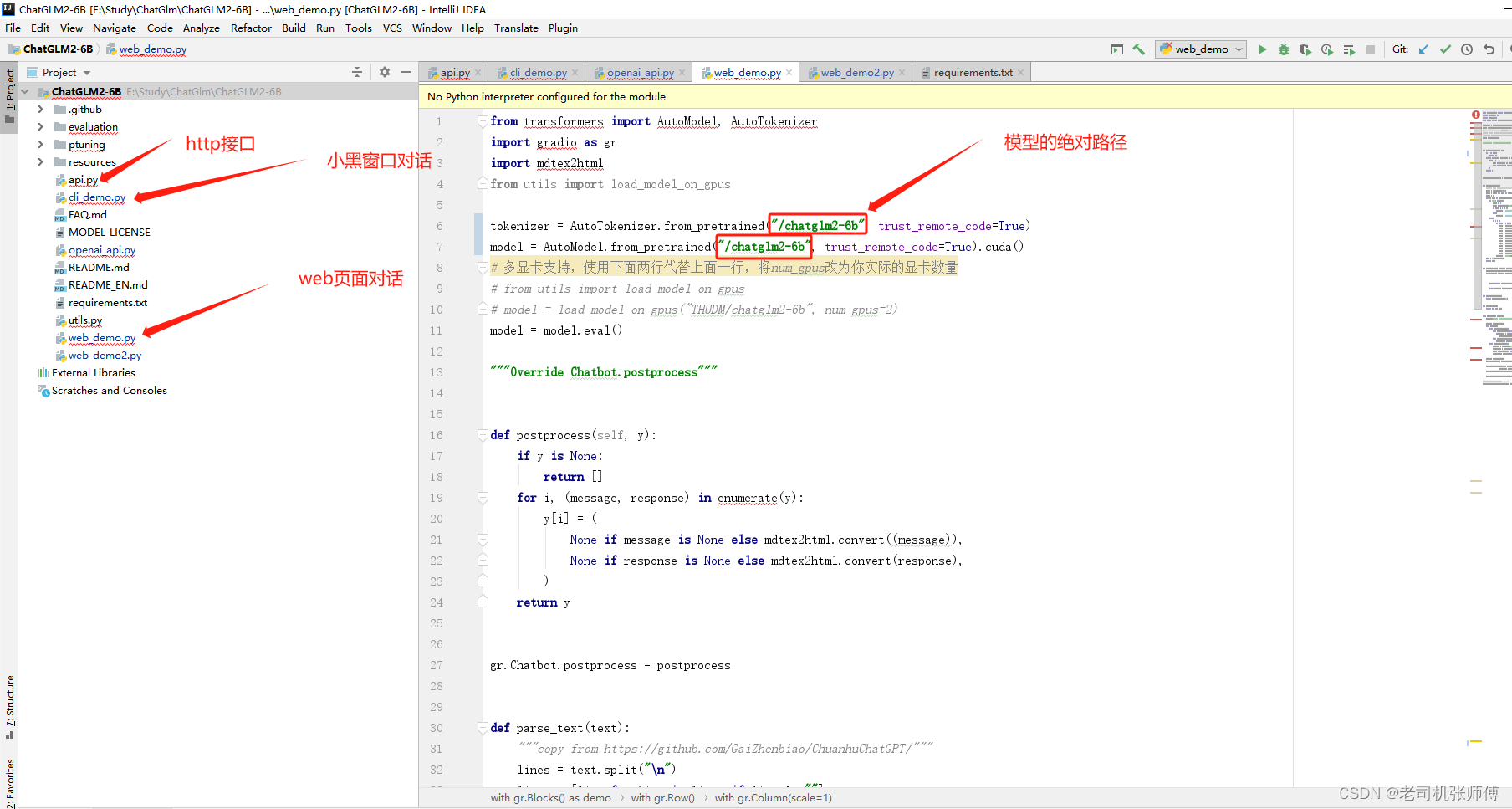

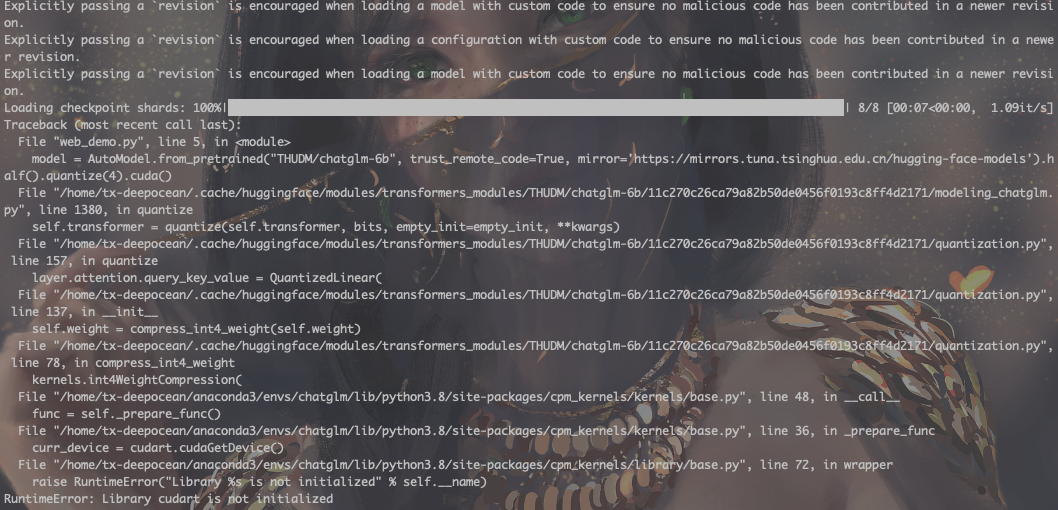

ChatGLM2-6B 部署与微调

文章目录 一、ChatGLM-6B二、ChatGLM2-6B三、本地部署ChatGLM2-6B3.1 命令行模式3.2 网页版部署3.3 本地加载模型权重3.4 模型量化3.5 CPU部署3.6 多卡部署 四、P-tuning v2微调教程4.1 P-tuning v2 原理4.2 P-tuning v2微调实现4.2.1 安装依赖,下载数据集4.2.2 开始…

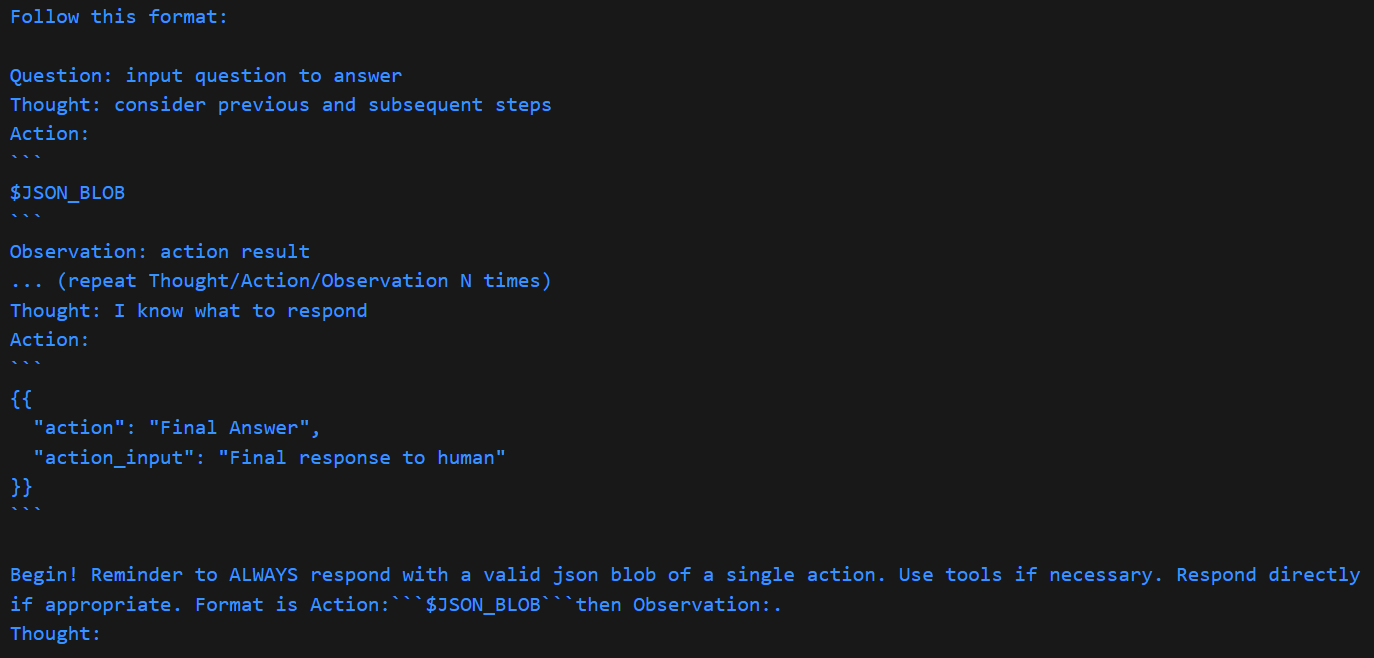

一文读懂Langchain:ChatGLM3和ChatGPT的Agent调用尝试

文章目录 关于AgentChatGPT的Agent能力测试工具定义模型定义工具导入Agent类型Agent测试提示词分析解析算法分析 关于Agent

Agent的中文名叫做代理或者智能体,和一般的对话模式相比,进入Agent模式的大模型,具有更多的自我意识和独立思考能力…

GPT实战系列-Baichuan2等大模型的计算精度与量化

GPT实战系列-Baichuan2等大模型精度与量化

不做特别处理,深度学习默认参数精度为浮点32位精度(FP32)。大模型参数庞大,10-1000B级别,如果不注意优化,既耗费大量的显卡资源,也耗费大量的训练时间…

GPT实战系列-ChatGLM2部署Ubuntu+Cuda11+显存24G实战方案

GPT实战系列-ChatGLM2部署UbuntuCuda11显存24G实战方案

自从chatGPT掀起的AI大模型热潮以来,国内大模型研究和开源活动,进展也如火如荼。模型越来越大,如何在小显存部署和使用大模型?

本实战专栏将评估一系列的开源模型…

ChatGLM2-6B微调实践

ChatGLM2-6B微调实践 环境准备安装部署1、安装 Anaconda2、安装CUDA3、安装PyTorch4、安装 ChatGLM2-6B 微调实践1、准备数据集2、安装python依赖3、微调并训练新模型4、微调后模型的推理与评估5、验证与使用微调后的模型 微调过程中遇到的问题 环境准备

申请阿里云GPU服务器&…

Chatglm2-6b模型相关问题

Chatglm2-6b模型相关问题 1. Chatglm2-6b模型p-tuning后推理答非所问 1. Chatglm2-6b模型p-tuning后推理答非所问

据ChatGLM-6B b站的说法:【官方教程】ChatGLM-6B 微调:P-Tuning,LoRA,Full parameter大概意思就是练了后面的前面…

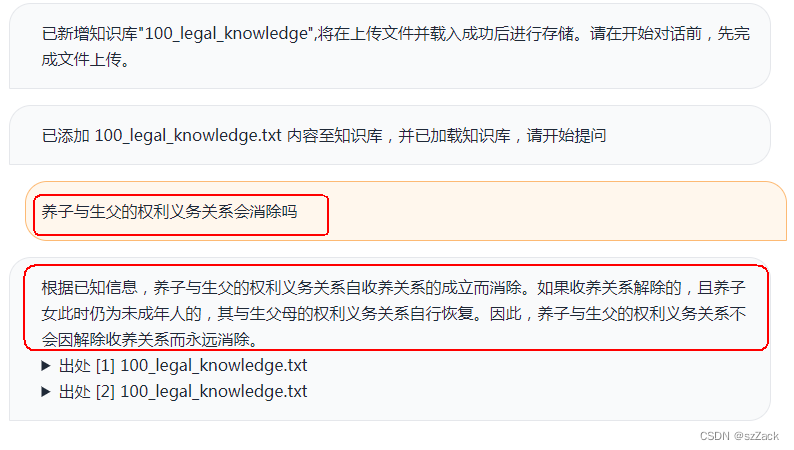

M3EChatGLM向量化构建本地知识库

M3E&ChatGLM向量化构建本地知识库 整体步骤向量数据库向量数据库简介主流数据库Milvus部署 文本向量化M3E介绍模型对比M3E使用向量数据存储 基于本地知识库的问答问句向量化向量搜索请求ChatGLM问答测试 整体步骤

向量化:首先,你需要将语言模型的数…

LLM大语言模型(三):使用ChatGLM3-6B的函数调用功能前先学会Python的装饰器

目录 ChatGLM3-6B的函数调用模式示例

本地启动ChatGLM3-6B工具模式

如何在ChatGLM3-6B里新增一个自定义函数呢?

get_weather基于Python的装饰器实现

函数注解register_tool

现在我们来自定义一个kuakuawo()函数 ChatGLM3-6B的函数调用模式示例

ChatGLM3-6B目前…

使用ChatGLM3自定义工具实现大模型查询MySQL数据库

ChatGLM3-6B 采用了全新设计的 Prompt 格式,除正常的多轮对话外。同时原生支持工具调用(Function Call)、代码执行(Code Interpreter)和 Agent 任务等复杂场景。

什么是工具调用

大模型虽然强大,但是由于…

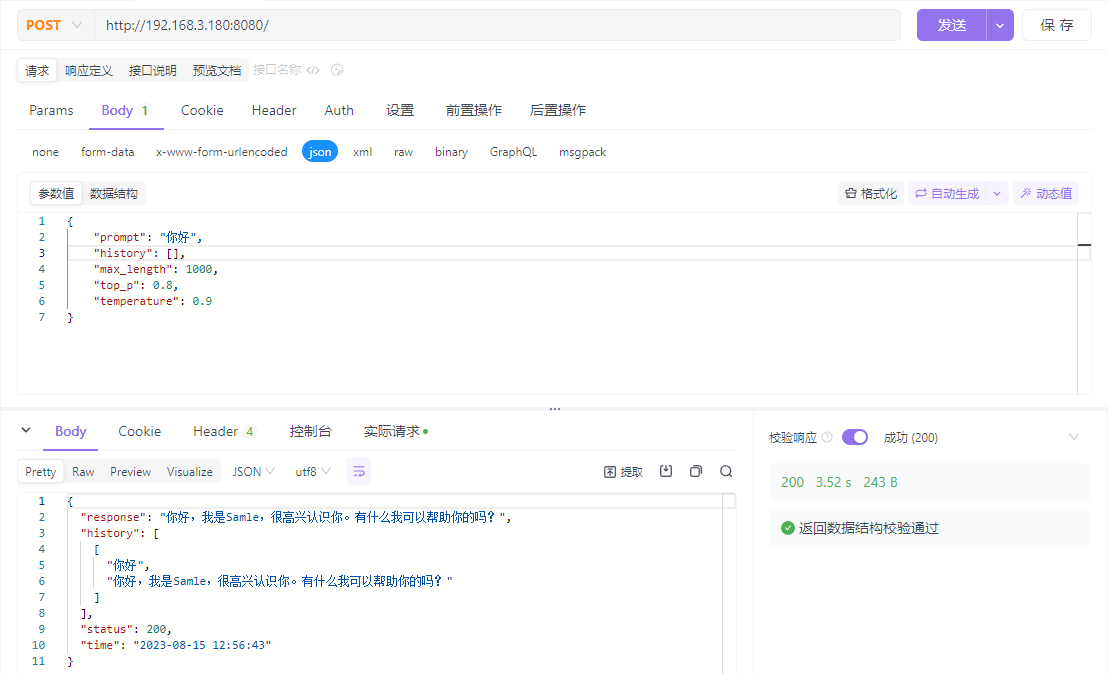

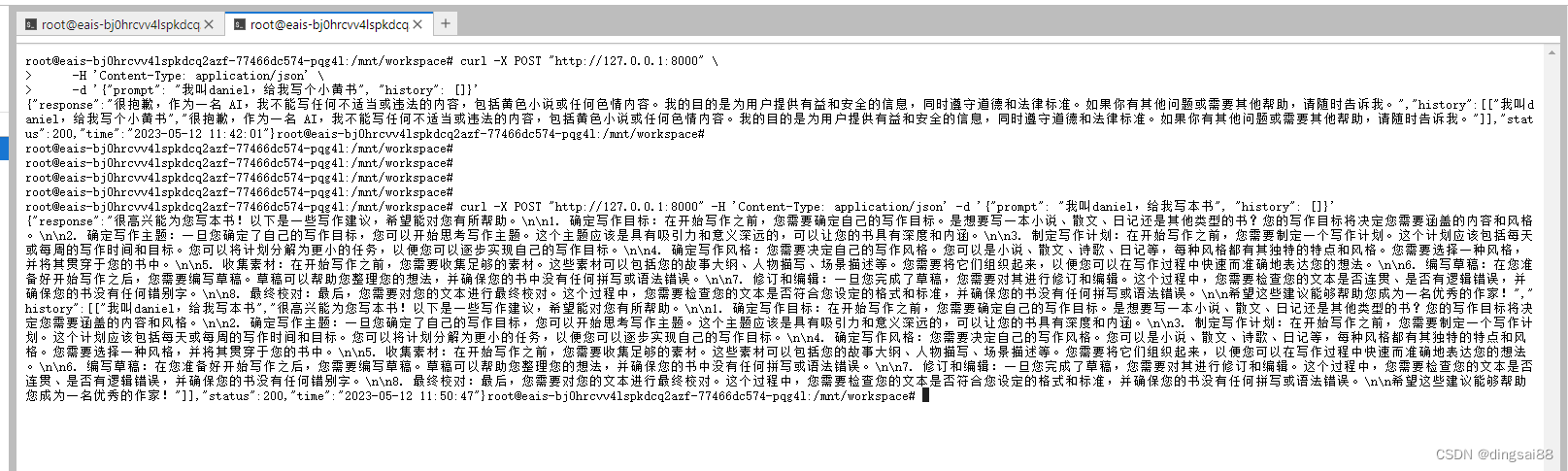

【开源】给ChatGLM写个,Java对接的SDK

作者:小傅哥 - 百度搜 小傅哥bugstack 博客:bugstack.cn 沉淀、分享、成长,让自己和他人都能有所收获!😄 大家好,我是技术UP主小傅哥。

清华大学计算机系的超大规模训练模型 ChatGLM-130B 使用效果非常牛&…

使用LLaMA-Factory微调ChatGLM3

1、创建虚拟环境

略

2、部署LLaMA-Factory

(1)下载LLaMA-Factory

https://github.com/hiyouga/LLaMA-Factory

(2)安装依赖

pip3 install -r requirements.txt(3)启动LLaMA-Factory的web页面

CUDA_VI…

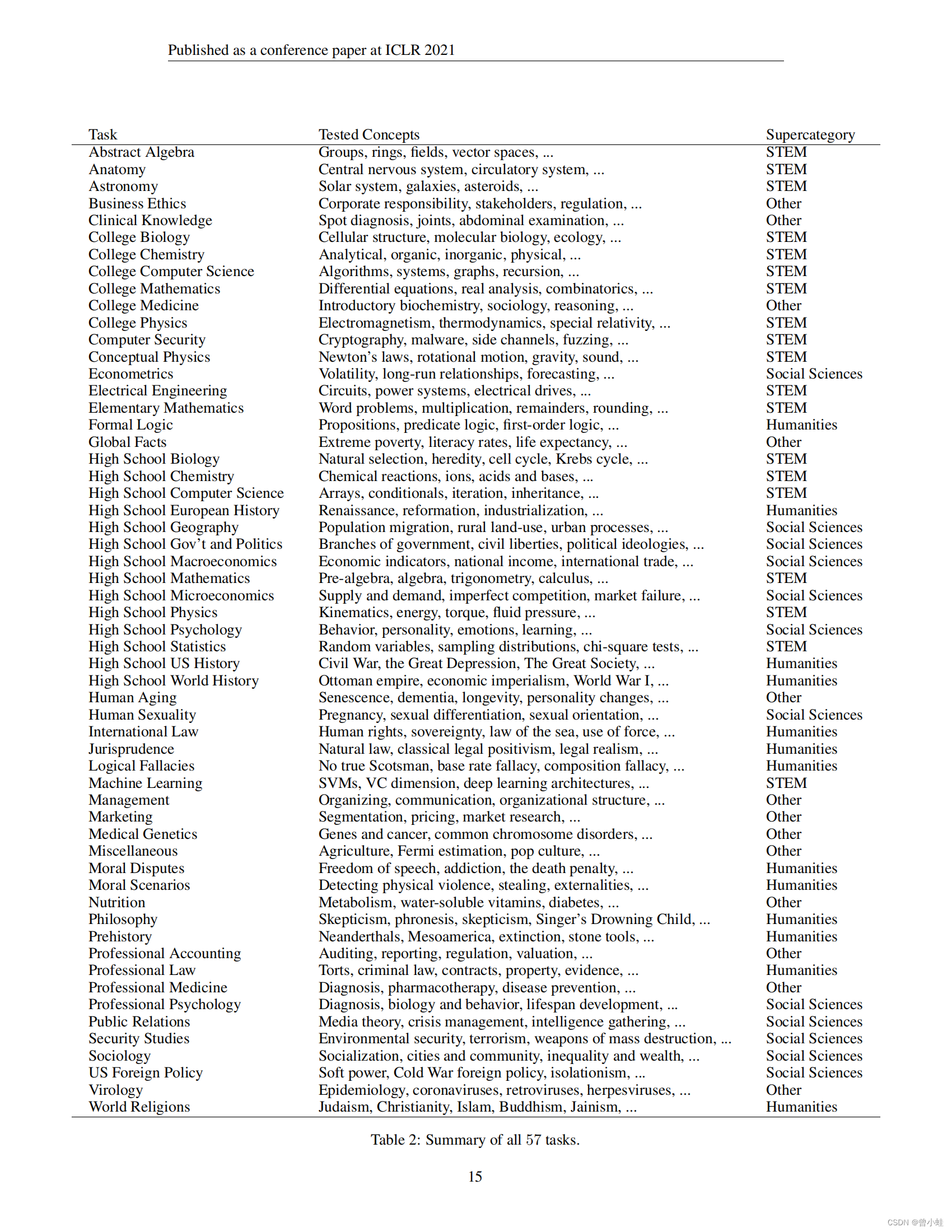

【GPT】中文大语言模型梳理与测评(C-Eval 、AGIEval、MMLU、SuperCLUE)

文章目录 概述申请后直接使用大模型开源可本地部署 通识数据集测评(C-Eval 、AGIEval、MMLU、SuperCLUE)自媒体报道SuperCLUE:中文通用大模型综合性基准C-Eval:中英测评(清华上交提出)当前排名(…

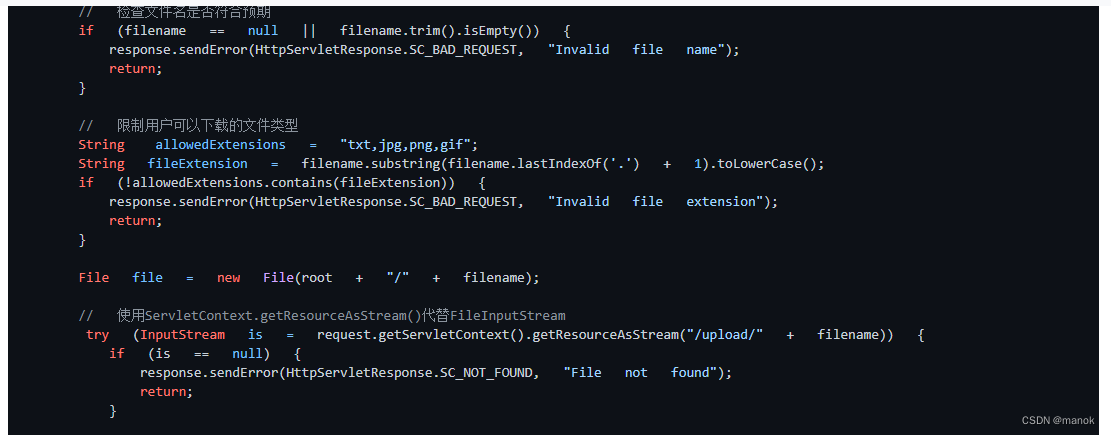

几款AI工具代码安全漏洞分析能力对比

这段时间研究AI平台的能力。 今天我把库博检测工具发现的一个Java安全漏洞相关代码传到几款AI工具上进行分析,看看这几款工具反馈的结果。这些工具包括ChatGPT-3.5、Forefront Claude、AIChat(组合)和清华ChatGlm。 首先我们看看库博检测出的…

Windows下cpu部署运行清华大学ChatGLM-6B语言模型(详解)

一、简介

ChatGLM-6B 清华大学实现的一个开源的、支持中英双语、支持图像理解的对话语言模型。它基于<

ChatGLM 6B 部署及微调 【干货】

代码地址、模型地址、安装环境:Ubuntu20.04,RTX3060 12G 一、部署

1.1 下载代码

cd /opt

git clone https://github.com/THUDM/ChatGLM2-6B1.2 下载模型

将模型下载后放到项目文件夹内

git lfs install # 确认安装了lfs,或者直接到项目地…

ModuleNotFoundError: No module named ‘transformers_modules.chatglm-6b_v1‘的解决方案

大家好,我是爱编程的喵喵。双985硕士毕业,现担任全栈工程师一职,热衷于将数据思维应用到工作与生活中。从事机器学习以及相关的前后端开发工作。曾在阿里云、科大讯飞、CCF等比赛获得多次Top名次。现为CSDN博客专家、人工智能领域优质创作者。喜欢通过博客创作的方式对所学的…

(非代码层面)优化自己的本地langchain-chatglm3的QA效果思路分享。(持续更新)

前言

本篇不讲代码,仅分享一些优化自己处理QA任务的向量库大模型的方法。

背景

一、 大家有时制作基于langchain创建具有知识库的的本地GLM模型,在执行QA任务时。会发现效果会明显的差过智谱的智能体。个人认为原因主要是:

模型大小&…

GPT实战系列-智谱GLM-4的模型调用

GPT实战系列-智谱GLM-4的模型调用

GPT专栏文章:

GPT实战系列-实战Qwen通义千问在Cuda 1224G部署方案_通义千问 ptuning-CSDN博客

GPT实战系列-ChatGLM3本地部署CUDA111080Ti显卡24G实战方案

GPT实战系列-Baichuan2本地化部署实战方案

GPT实战系列-让CodeGeeX2帮…

深度学习实战50-构建ChatOCR项目:基于大语言模型的OCR识别问答系统实战

大家好,我是微学AI,今天给大家介绍一下深度学习实战50-构建ChatOCR项目:基于大语言模型的OCR识别问答系统实战,该项目是一个基于深度学习和大语言模型的OCR识别问答系统的实战项目。该项目旨在利用深度学习技术和先进的大语言模型,构建一个能够识别图像中文本,并能够回答与…

Linux,使用魔搭modelscope下载ChatGLM3-6B-32K大模型

1.进入命令行

2.pip安装modelscope

pip install modelscope

3.进入python

python

4.引入snapshot_download

from modelscope import snapshot_download

5. 下载模型,cache_dir是大模型的保存路径

model_dir snapshot_download("ZhipuAI/chatglm3-6b-3…

【LLM】大语言模型高效微调方案Lora||直击底层逻辑

敬请期待... Reference

深入浅出剖析 LoRA 技术原理_lora csdn-CSDN博客

【OpenLLM 006】LoRA:大模型的低秩适配-最近大火的lora到底是什么东西?为啥stable diffusion和开源ChatGPT复现都在用? - 知乎 (zhihu.com)

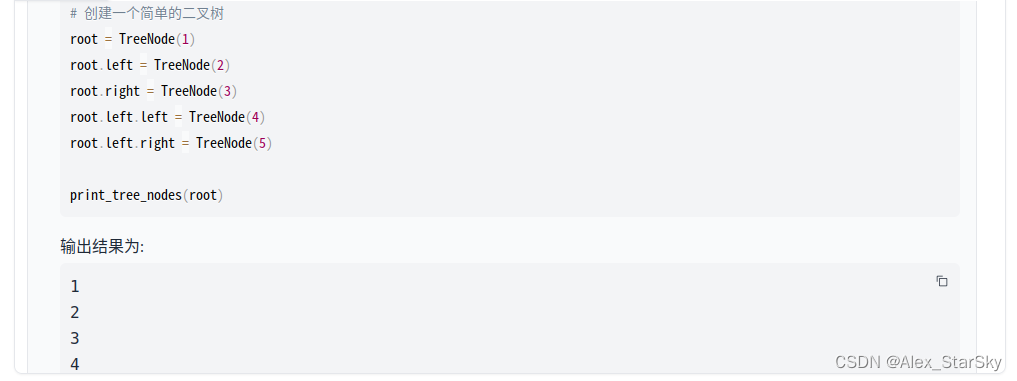

【自然语言处理】【大模型】ChatGLM-6B模型结构代码解析(单机版)

ChatGLM-6B模型结构代码解析(单机版) 本文介绍ChatGLM-6B的模型结构,代码来自https://huggingface.co/THUDM/chatglm-6b/blob/main/modeling_chatglm.py。 相关博客 【自然语言处理】【大模型】ChatGLM-6B模型结构代码解析(单机版) 【自然语言处理】【大模型】BL…

LLM大语言模型(一):ChatGLM3-6B试用

前言

LLM大语言模型工程化,在本地搭建一套开源的LLM,方便后续的Agent等特性的研究。

本机环境

CPU:AMD Ryzen 5 3600X 6-Core Processor

Mem:32GB

GPU:RTX 4060Ti 16G

ChatGLM3代码库下载

# 下载代码库

git c…

ChatGPT 本地部署及搭建

这篇简要说下清华开源项目 ChatGLM 本地部署的详细教程。清华开源项目 ChatGLM-6B 已发布开源版本,这一项目可以直接部署在本地计算机上做测试,无需联网即可体验与 AI 聊天的乐趣。

项目地址:GitHub - THUDM/ChatGLM-6B: ChatGLM-6B…

ChatGLM的搭建过程

本次搭建的是清华大学开源的ChatGLM。源码地址。模型地址。

1、开启BBR加速

如何开启BBR加速可以去看我的这篇文章,Linux开启内核BBR加速。

2、拉取ChatGLM源码和ChatGLM模型

点击这里跳转到源码处。

点击这里跳转到模型下载处。

我这里在下载之前创建了一个目…

win10 安装 langchain-chatglm 避坑指南(2023年6月21日最新版本)

官网看起来安装很简单,网上教程也是,但实际上我耗费了两天时间,查阅了当前网络上所有可查阅的资料,重复「安装-配置-卸载」十几遍,总结出的安装方法。 1、安装Anaconda(这个就不啰嗦了,网上安装…

【ChatGLM3】第三代大语言模型多GPU部署指南

关于ChatGLM3

ChatGLM3是智谱AI与清华大学KEG实验室联合发布的新一代对话预训练模型。在第二代ChatGLM的基础之上,

更强大的基础模型: ChatGLM3-6B 的基础模型 ChatGLM3-6B-Base 采用了更多样的训练数据、更充分的训练步数和更合理的训练策略。在语义、…

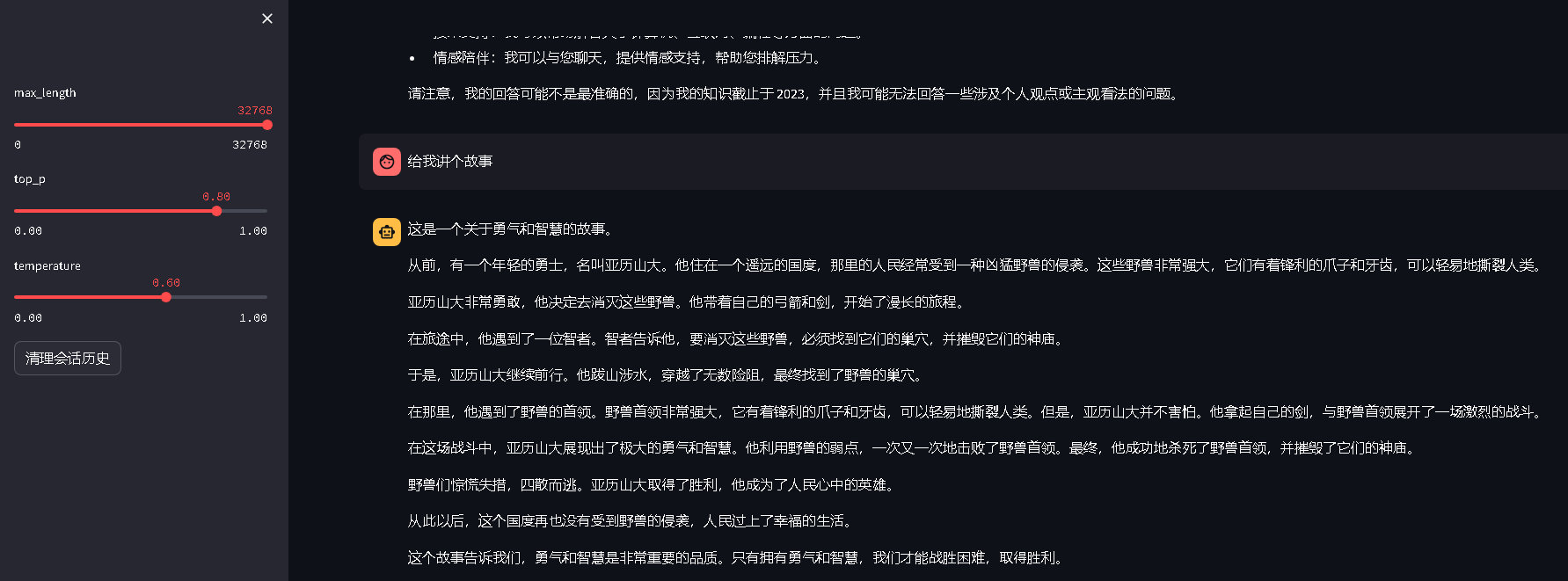

ChatGLM:CPU版本如何安装和部署使用

前段时间想自己部署一个ChatGLM来训练相关的物料当做chatgpt使用,但是奈何没有gpu机器,只能使用cpu服务器尝试使用看看效果 我部署的 Chinese-LangChain 这个项目,使用的是LLM(ChatGLM)embedding(GanymedeNil/text2vec…

快速部署本地知识库大模型(Langchain+ChatGLM3)

使用AutoDL AI算力云:AutoDL算力云 | 弹性、好用、省钱。租GPU就上AutoDL,注册后充值后进入控制台 点击租用新实例,选择机器和社区镜像langchain-chatchat如下 创建成功后进去JupyterLab 打开终端运行如下命令

$ cd /root/Langchain-Chatch…

清华大学ChatGLM-6B部署运行

一、模型介绍

开源项目:

GitHub - THUDM/ChatGLM-6B: ChatGLM-6B:开源双语对话语言模型 | An Open Bilingual Dialogue Language Model ChatGLM-6B 是一个开源的、支持中英双语的对话语言模型,基于 General Language Model (GLM) 架构&…

【LLM】chatglm-6B模型训练和推理

本篇文章记录下 chatglm-6B 训练和推理过程 环境:Ubuntu 20.04 1.13.0cu116 chatglm-6B 源代码仓库:链接 chatglm-6B 模型权重:链接

源代码及模型 clone 到本地

这里使用的是 THUDM 在 hugging face 开源的模型。 因为模型比较大ÿ…

chatglm3-6b部署及微调

chatglm3-6b部署及微调

modelscope: https://modelscope.cn/models/ZhipuAI/chatglm3-6b/filesgithub: https://github.com/THUDM/ChatGLM3镜像: ubuntu20.04-cuda11.8.0-py38-torch2.0.1-tf2.13.0-1.9.4v100 16G现存 单卡

安装

软件依赖

pip install --upgrade pippip ins…

2023 Google 开发者大会:基于 TensorFlow 造就活色生香的膳食生成艺术

文章目录 前言一、关于 Google 开发者大会1.1、什么是 Google 开发者大会?1.2、CSDN 上线 2023 Google 开发者大会专题页 二、关于吃的话题2.1、食物选择的普遍性2.2、探讨食物的重要性 三、健康饮食中的食材感知与关联探讨3.1、项目团队组建及研发进展3.2、基于小样…

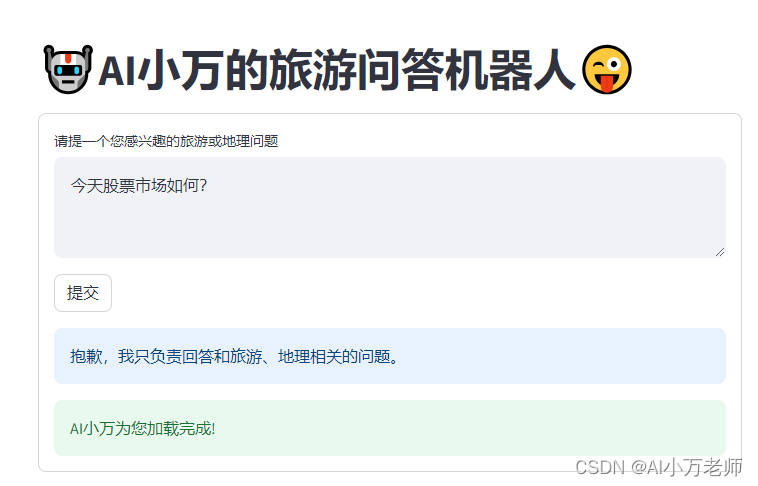

【Langchain+Streamlit】打造一个旅游问答AI

利用LangchainStreamlit打造一个交互简单的旅游问答AI机器人,如果你有openai账号,可以按照如下的网址直接体验,如果你没有的话可以站内私信博主要一下临时key体验一下: 产品使用传送门—— http://101.33.225.241:8501/ 这里有演示效果和代码…

大语言模型LangChain+ChatGLM3-6B的本地知识库与行业知识库价值体现

文章目录 大语言模型LangChainChatGLM3-6B的本地知识库与行业知识库价值体现引言本地知识库与行业知识库的重要性LangChain在知识库管理中的应用应用场景分析展望 大语言模型LangChainChatGLM3-6B的本地知识库与行业知识库价值体现

引言

在人工智能的浪潮中,大型语…

两小时搭建属于自己的chatGPT(ChatGLM)免硬件(白嫖)

目录

准备(注册):

搭建:

API模式:

测试:

总结: 准备(注册): 注册modelscope(白嫖)免费使用服务器

https://modelscope.cn/ 按照图片里的选择(选择其他好像不能创建成功) 可以白嫖60多个小时的配置

8…

两小时搭建属于自己的chatGPT(ChatGLM)免硬件(白嫖)

目录

准备(注册):

搭建:

API模式:

测试:

总结: 准备(注册): 注册modelscope(白嫖)免费使用服务器

https://modelscope.cn/ 按照图片里的选择(选择其他好像不能创建成功) 可以白嫖60多个小时的配置

8…

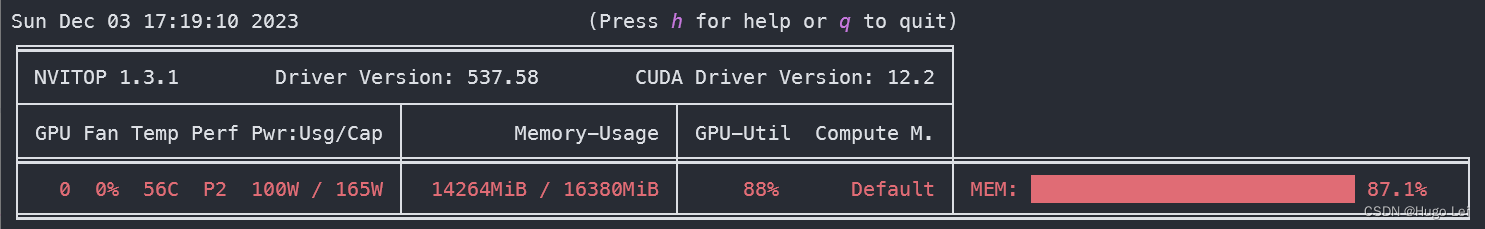

LLM大语言模型(一):ChatGLM3-6B本地部署

目录 前言

本机环境

ChatGLM3代码库下载

模型文件下载

修改为从本地模型文件启动

启动模型网页版对话demo

超参数设置

GPU资源使用情况 (网页对话非常流畅) 前言

LLM大语言模型工程化,在本地搭建一套开源的LLM,方便后续的…

GPT实战系列-探究GPT等大模型的文本生成

GPT实战系列-探究GPT等LLM文本生成

GPT专栏文章:

GPT实战系列-Baichuan2等大模型的计算精度与量化-CSDN博客

GPT实战系列-GPT训练的Pretraining,SFT,Reward Modeling,RLHF-CSDN博客

GPT实战系列-ChatGLM3本地部署CUDA111080Ti…

LangChain_ChatGLM部署

环境准备

项目地址:https://github.com/imClumsyPanda/langchain-ChatGLM 下载chatglm-6b模型到本地,大约13G: https://huggingface.co/THUDM/chatglm-6b 里面的文件需要一个个手动点击下载,点击下载时,可能需要多次点…

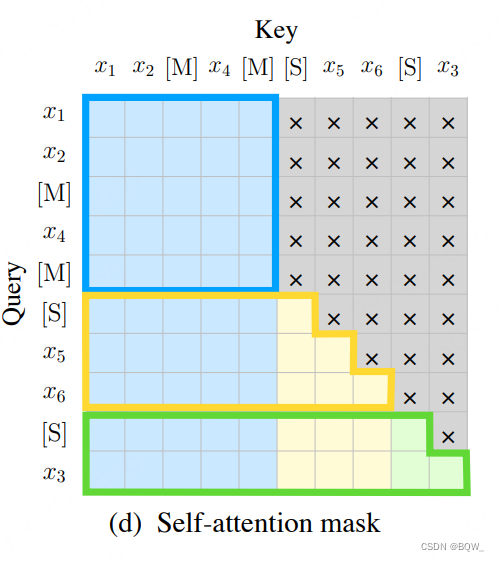

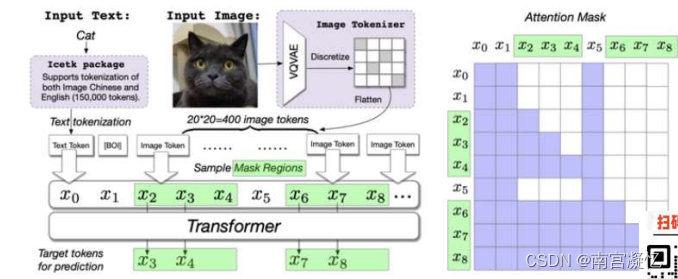

ChatGLM vs ChatGPT

所有的NLP大模型 都是transformer结构

1.Mask attention 的策略不同

2.训练任务目标不同 国内大模型nb公司:百度、清华智谱

一、主流大模型 粉色:Encoder-only。

绿色:Encoder-Decoder,尽头智谱ChatGLM。

蓝色:…

ChatGLM-6B (介绍相关概念、基础环境搭建及部署)

文章目录 前言一、ChatGLM-6B是什么?二、安装虚拟的python环境1.下载2.安装3.设置国内源(危险)4.虚拟环境使用简介 三、部署ChatGLM-6B1. clone代码2. 运行1.创建虚拟环境2.装包2.1 找到合适的pytorch版本2.1 安装依赖2.2 验证pytorch是否为GPU版本 3.运行 四、部署…

‘ChatGLMTokenizer‘ object has no attribute ‘tokenizer‘解决方案

大家好,我是爱编程的喵喵。双985硕士毕业,现担任全栈工程师一职,热衷于将数据思维应用到工作与生活中。从事机器学习以及相关的前后端开发工作。曾在阿里云、科大讯飞、CCF等比赛获得多次Top名次。现为CSDN博客专家、人工智能领域优质创作者。喜欢通过博客创作的方式对所学的…

【优质书籍推荐】LoRA微调的技巧和方法

大家好,我是爱编程的喵喵。双985硕士毕业,现担任全栈工程师一职,热衷于将数据思维应用到工作与生活中。从事机器学习以及相关的前后端开发工作。曾在阿里云、科大讯飞、CCF等比赛获得多次Top名次。现为CSDN博客专家、人工智能领域优质创作者。…

体验 langchain-ChatGLM

体验 langchain-ChatGLM 1. 什么是 langchain-ChatGLM2. 什么是 langchain3. Github 地址4. 安装 Miniconda35. 创建虚拟环境6. 部署 langchain-ChatGLM7. 启动 langchain-ChatGLM8. 访问 langchain-ChatGLM9. API部署10. 命令行部署11. 其他,LangChain Document Lo…

ubuntu22.04CPU部署ChatGLM笔记

ChatGLM官方Github链接 https://github.com/THUDM/ChatGLM-6B

我就是一步步按照官方部署教程完成ChatGLM部署。对于官方文档里面详细描述的部署步骤不进一步赘述。这里主要记录几个自己遇到的问题

1 安装环境及依赖

ChatGLM部署需要安装python, pytorch等环境,为…

LLM大语言模型(四):在ChatGLM3-6B中使用langchain

目录 背景准备工作工具添加LangChain 已实现工具Calculator、Weather Tool配置 自定义工具自定义kuakuawo Agent 多工具使用参考 背景

LangChain是一个用于开发由语言模型驱动的应用程序的框架。它使应用程序能够:

具有上下文意识:将语言模型与上下文源(提示指令&…

【AI实战】给类ChatGPT的大语言模型外挂私有知识库

【AI实战】给类ChatGPT的大语言模型外挂私有知识库 原理准备环境代码下载 chatglm-6b 模型权重文件下载 Embedding 模型 GanymedeNil/text2vec-large-chinese安装依赖库我的计算资源 外挂知识库开启服务外挂知识库 测试参考 本文使用 langChain 来给大语言模型 ChatGLM-6B 外挂…

“超级AI助手:全新提升!中文NLP训练框架,快速上手,海量训练数据,ChatGLM-v2、中文Bloom、Dolly_v2_3b助您实现更智能的应用!”

“超级AI助手:全新提升!中文NLP训练框架,快速上手,海量训练数据,ChatGLM-v2、中文Bloom、Dolly_v2_3b助您实现更智能的应用!”

1.简介

目标:基于pytorch、transformers做中文领域的nlp开箱即用…

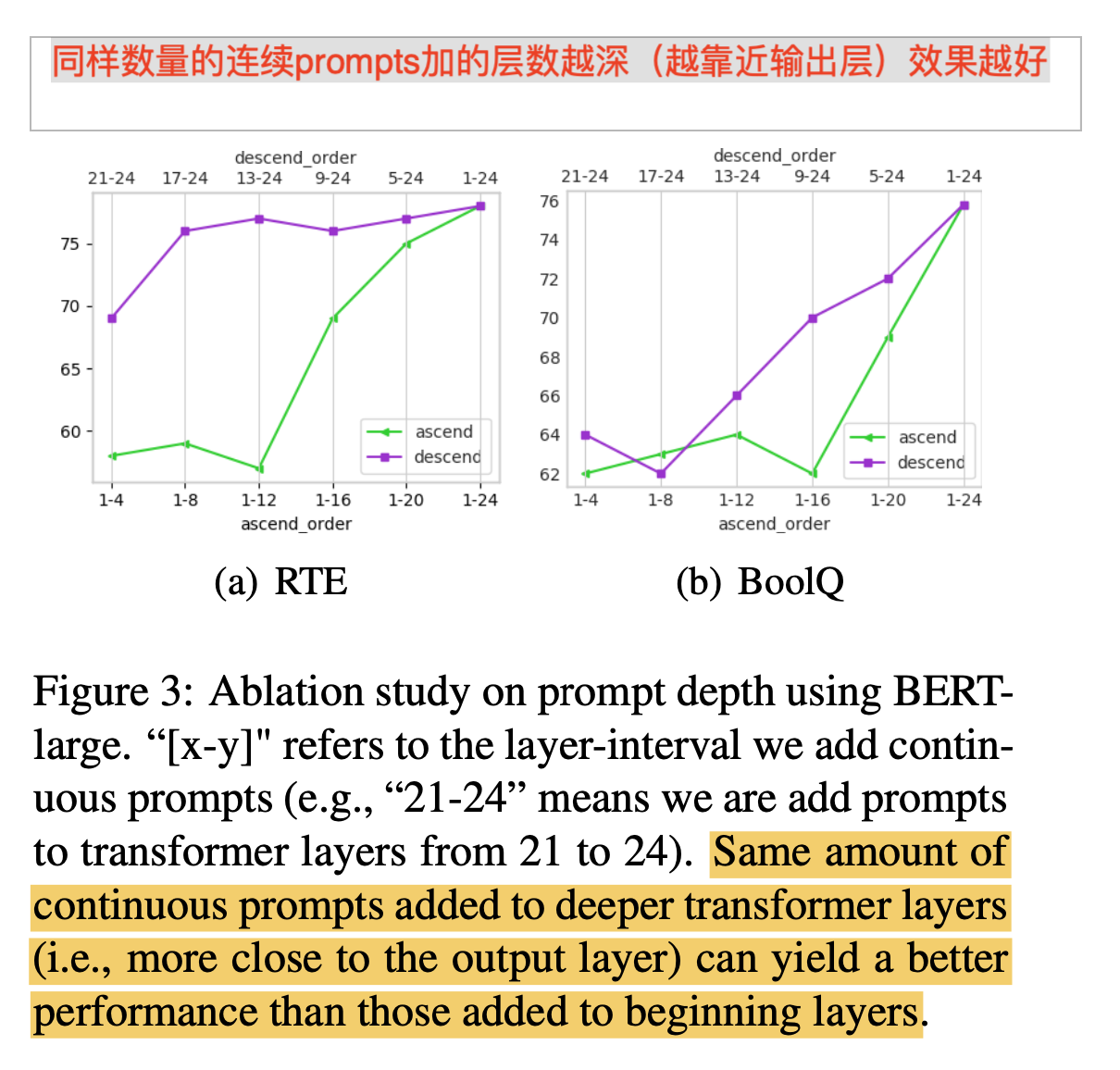

ACL 2022 | chatglm微调神器P-Tuning v2论文学习

一、概述

title:P-Tuning v2: Prompt Tuning Can Be Comparable to Fine-tuning Universally Across Scales and Tasks

论文地址:https://arxiv.org/abs/2110.07602

代码:GitHub - THUDM/P-tuning-v2: An optimized deep prompt tuning st…

生成 Cypher 能力:GPT3.5 VS ChatGLM

生成 Cypher 能力:GPT3.5 VS ChatGLM 生成 Cypher 能力:GPT3.5 VS ChatGLM一、 测试结果二、 测试代码(包含Prompt) Here’s the table of contents: 生成 Cypher 能力:GPT3.5 VS ChatGLM 在之前的文章中已经测试过GPT…